# 微应用版本安装

文档中以 Linux(Centos7) 操作系统、 MySQL 数据库为示例进行安装。

# 第一步.安装介质准备

1.数据资产微服务版:Primeton_DAMP_7.3.1_MicroApp.tar.gz(包含DAMP前后端和服务引擎)

2.EOS8.3.1基础环境:

EOS_Platform_8.3.1_Private_Medium_Application.tar.gz(基础运行环境,必须)

EOS_Platform_8.3.1_Private_Medium_Service.tar.gz(可选,主要涉及到日志采集和监控模块)

5.Nginx:推荐使用1.20.1版本。(必须)

6.Redis:推荐使用6.2.6版本。(必须)

7.ElasticSearch:推荐使用7.17.9版本,如果已经安装了EOS_Platform_8.3.1_Private_Medium_Service.tar.gz,则不需要再单独安装。(必须)

8.JDK:推荐使用Oracle JDK1.8.0_162。(必须)

9.filebeat:使用ElasticSearch配套的7.17.9版本。(服务日志采集组件,可选)

10.logstash:使用ElasticSearch配套的7.17.9版本。(服务日志采集组件,可选)

11.MetaCube:元数据7.5GA版本(必须)

Primeton_MetaCube_7.5GA_Extractor.tar

Primeton_MetaCube_7.5GA_Server.tar

Primeton_MetaCube_7.5GA_UI.tar

# 第二步.安装EOS_Platform_8.3.1基础环境

安装步骤详见EOS8.3.1环境搭建。

PS:文档默认安装目录是/opt/primeton,该路径可以自行修改,注意修改后下述文件路径自行调整。

可能需要修改路径的配置:

1.nginx路由配置,对于web静态资源访问路径需要根据实际情况修改。

/opt/primeton/web/conf/eos8.conf

/opt/primeton/web/conf/metacube.conf(如果独立定义元数据server)

# 第三步.数据库初始化

# 创建数据库用户/Schema

创建 damp 数据库。以Mysql为例,执行如下脚本:

CREATE DATABASE `damp` DEFAULT CHARACTER SET utf8mb4;

# 执行初始化脚本

微应用安介质安装时需要按顺序执行对应数据库的数据库初始化脚本。初始化脚本路径为 Primeton_DAMP_7.3.1_Server/db-scripts/,根据不同数据库类型做了不同的目录。目前已经适配的数据库包括Mysql5.7、Postgresql12、达梦V8、人大金仓V8R6、高斯openGuass 5.0.0、ORACLE 19c。

目前数据库脚本一共分成了4部分,分别是bfp、eos、lowcode和damp。 其中bfp、eos、lowcode作为基础组建依赖,都需要在damp库中做初始化,默认执行all.sql即可。 damp中包含了afcenter和bps的数据初始化内容,需要分别在damp、afcenter、bps三个库中执行对应脚本。

以Mysql为例,按顺序执行如下脚本:

1)在damp数据库下执行:

1.bfp

db-scripts/bfp/Mysql/all.sql

2.eos

db-scripts/eos/Mysql/all.sql

3.lowcode

db-scripts/lowcode/Mysql/all.sql

4.damp

db-scripts/damp/Mysql/dam-all.sql

2)在afcenter数据库下执行:

1.db-scripts/damp/Mysql/dam-afc-all.sql #需要先完成afcenter基础环境数据库的初始化

3)在bps数据库下执行:

1.db-scripts/damp/Mysql/dam-bps-all.sql #需要先完成bps基础环境数据库的初始化

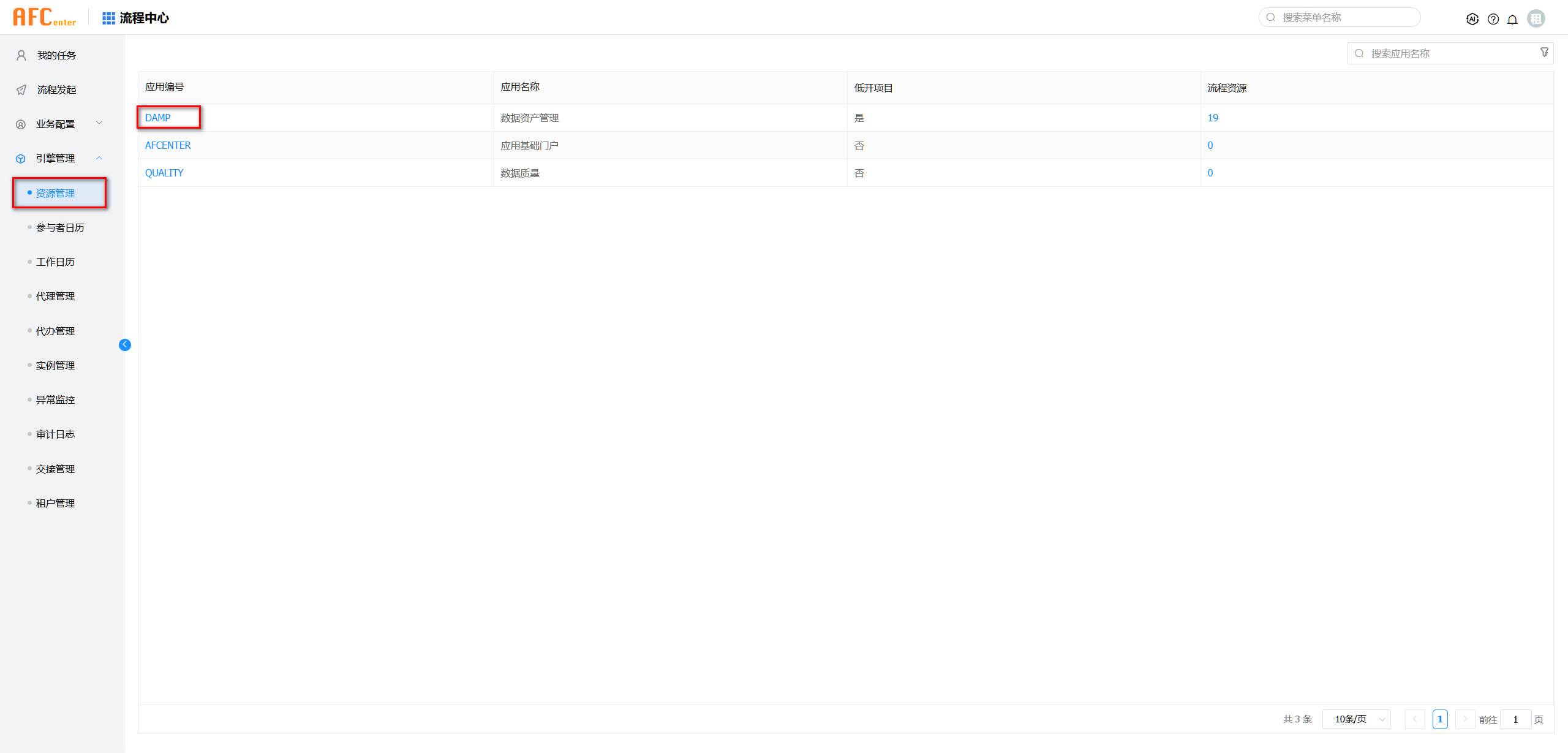

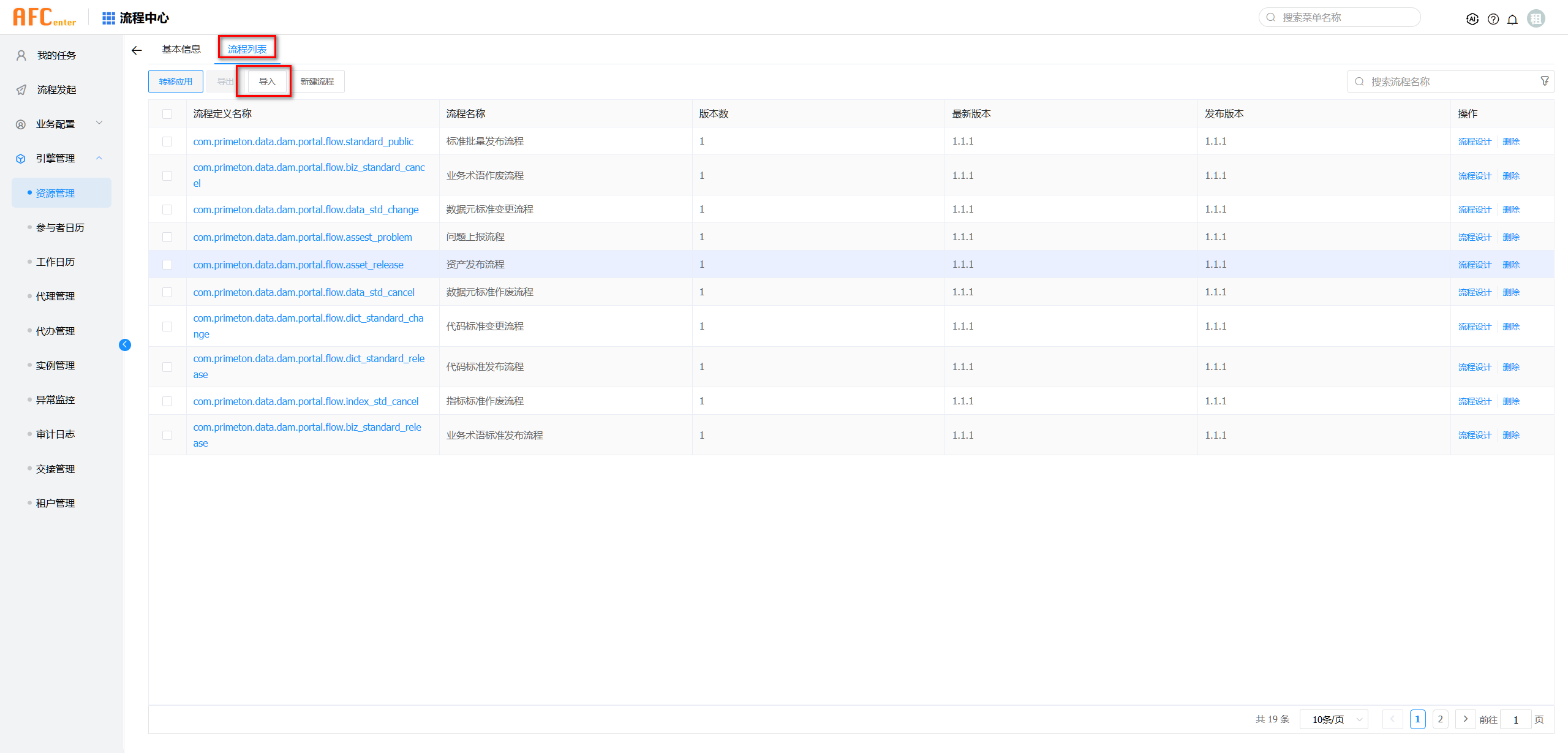

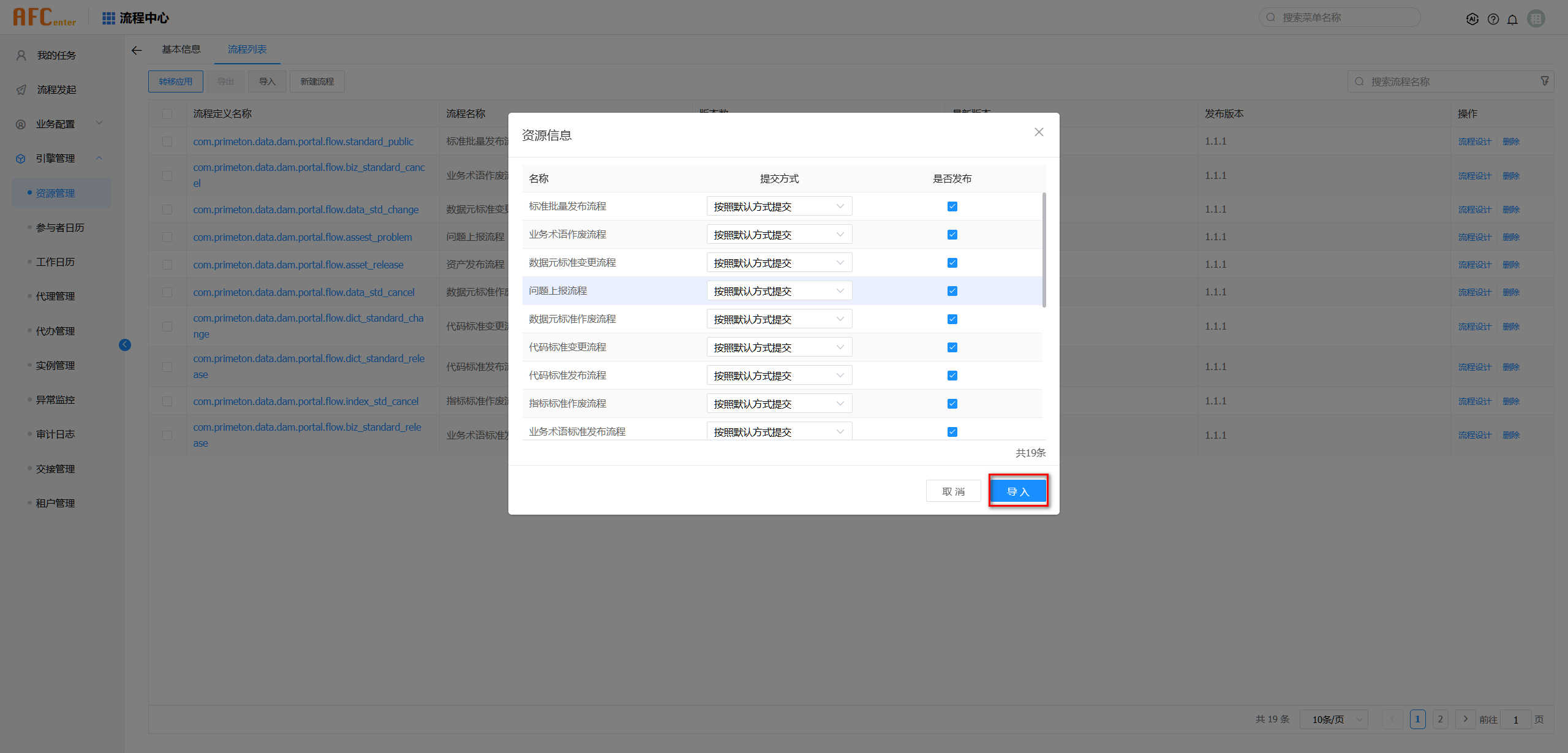

注意:ORACLE数据库没有数据库初始化化脚本需要使用流程部署包(damp/damp_flow_7.3.1.par)流程中心导入。 1.使用admin账号登录系统后进入”流程中心“。 2.点击菜单栏”引擎管理-资源管理“进入资源管理页面。

导入后,在bps数据库下执行下面sql,不是通过par包导入的无需执行。

DELETE FROM WFPROCESSDEFPROPERTIES where PROCESSDEFNAME like 'com.primeton.data.dam.portal.flow.%';

INSERT INTO "WFPROCESSDEFPROPERTIES" VALUES (71, 'com.primeton.data.dam.portal.flow.standard_public', '${userName}于${dateTime}发起了${names}的${processChName}', NULL, 'DAMP', NULL, NULL, NULL, NULL, 0, NULL);

INSERT INTO "WFPROCESSDEFPROPERTIES" VALUES (72, 'com.primeton.data.dam.portal.flow.biz_standard_cancel', '${userName}于${dateTime}发起了${term.standardZhName}的${processChName}', NULL, 'DAMP', NULL, NULL, NULL, NULL, 0, NULL);

INSERT INTO "WFPROCESSDEFPROPERTIES" VALUES (73, 'com.primeton.data.dam.portal.flow.data_std_change', '${userName}于${dateTime}发起了${standarDataelement.standardZhName}的${processChName}', NULL, 'DAMP', NULL, NULL, NULL, NULL, 0, NULL);

INSERT INTO "WFPROCESSDEFPROPERTIES" VALUES (74, 'com.primeton.data.dam.portal.flow.assest_problem', '${userName}于${dateTime}发起了${quest.problemTotic}的${processChName}', NULL, 'DAMP', NULL, NULL, NULL, NULL, 0, NULL);

INSERT INTO "WFPROCESSDEFPROPERTIES" VALUES (75, 'com.primeton.data.dam.portal.flow.asset_release', '${userName}于${dateTime}发起了${cataTitle}的${processChName}', NULL, 'DAMP', NULL, NULL, NULL, NULL, 0, NULL);

INSERT INTO "WFPROCESSDEFPROPERTIES" VALUES (76, 'com.primeton.data.dam.portal.flow.data_std_cancel', '${userName}于${dateTime}发起了${standarDataelement.standardZhName}的${processChName}', NULL, 'DAMP', NULL, NULL, NULL, NULL, 0, NULL);

INSERT INTO "WFPROCESSDEFPROPERTIES" VALUES (77, 'com.primeton.data.dam.portal.flow.dict_standard_change', '${userName}于${dateTime}发起了${dict.standardName}的${processChName}', NULL, 'DAMP', NULL, NULL, NULL, NULL, 0, NULL);

INSERT INTO "WFPROCESSDEFPROPERTIES" VALUES (78, 'com.primeton.data.dam.portal.flow.dict_standard_release', '${userName}于${dateTime}发起了${dict.standardName}的${processChName}', NULL, 'DAMP', NULL, NULL, NULL, NULL, 0, NULL);

INSERT INTO "WFPROCESSDEFPROPERTIES" VALUES (79, 'com.primeton.data.dam.portal.flow.index_std_cancel', '${userName}于${dateTime}发起了${standardindex.standardName}的${processChName}', NULL, 'DAMP', NULL, NULL, NULL, NULL, 0, NULL);

INSERT INTO "WFPROCESSDEFPROPERTIES" VALUES (80, 'com.primeton.data.dam.portal.flow.biz_standard_release', '${userName}于${dateTime}发起了${term.standardZhName}的${processChName}', NULL, 'DAMP', NULL, NULL, NULL, NULL, 0, NULL);

INSERT INTO "WFPROCESSDEFPROPERTIES" VALUES (81, 'com.primeton.data.dam.portal.flow.asset_chenge', '${userName}于${dateTime}发起了${cataTitle}的${processChName}', NULL, 'DAMP', NULL, NULL, NULL, NULL, 0, NULL);

INSERT INTO "WFPROCESSDEFPROPERTIES" VALUES (82, 'com.primeton.data.dam.portal.flow.biz_standard_change', '${userName}于${dateTime}发起了${term.standardZhName}的${processChName}', NULL, 'DAMP', NULL, NULL, NULL, NULL, 0, NULL);

INSERT INTO "WFPROCESSDEFPROPERTIES" VALUES (83, 'com.primeton.data.dam.portal.flow.data_std_release', '${userName}于${dateTime}发起了${standarDataelement.standardZhName}的${processChName}', NULL, 'DAMP', NULL, NULL, NULL, NULL, 0, NULL);

INSERT INTO "WFPROCESSDEFPROPERTIES" VALUES (84, 'com.primeton.data.dam.portal.flow.index_std_release', '${userName}于${dateTime}发起了${standardindex.standardName}的${processChName}', NULL, 'DAMP', NULL, NULL, NULL, NULL, 0, NULL);

INSERT INTO "WFPROCESSDEFPROPERTIES" VALUES (85, 'com.primeton.data.dam.portal.flow.model_check', '${userName}于${dateTime}发起了${appName}的${processChName}', NULL, 'DAMP', NULL, NULL, NULL, NULL, 0, NULL);

INSERT INTO "WFPROCESSDEFPROPERTIES" VALUES (86, 'com.primeton.data.dam.portal.flow.index_std_change', '${userName}于${dateTime}发起了${standardindex.standardName}的${processChName}', NULL, 'DAMP', NULL, NULL, NULL, NULL, 0, NULL);

INSERT INTO "WFPROCESSDEFPROPERTIES" VALUES (87, 'com.primeton.data.dam.portal.flow.asset_apply', '${userName}于${dateTime}发起了${cataTitle}的${processChName}', NULL, 'DAMP', NULL, NULL, NULL, NULL, 0, NULL);

INSERT INTO "WFPROCESSDEFPROPERTIES" VALUES (88, 'com.primeton.data.dam.portal.flow.dict_standard_cancel', '${userName}于${dateTime}发起了${dict.standardName}的${processChName}', NULL, 'DAMP', NULL, NULL, NULL, NULL, 0, NULL);

INSERT INTO "WFPROCESSDEFPROPERTIES" VALUES (89, 'com.primeton.data.dam.portal.flow.model_chenge', '${userName}于${dateTime}发起了${appName}的${processChName}', NULL, 'DAMP', NULL, NULL, NULL, NULL, 0, NULL);

执行完毕后,重启bps后台服务。

# 第四步.DAMP 后端部署

# 1.解压介质

在/opt/primeton/server目录下创建 damp 文件夹,将 Primeton_DAMP_7.3.1_Server.tar.gz 复制到 damp 目录下并解压。

# 2.配置文件修改

微应用安介质安装时的配置文件,有需要修改的地方会在后面用“###”提示说明。

1.damp/config/application.properties #公共配置

2.damp/config/application-afc.properties #afcenter集成配置

3.damp/config/application-damp.properties #damp自身配置

4.damp/config/application-nacos.properties #nacos注册中心配置

5.damp/config/bootstrap.properties #nacos配置中心配置

6.damp/config/DAMP/config/user-config.xml #damp数据源配置

7.damp/config/application-dm.properties #7.2版本新增,用于建模模块配置

8.damp/config/application-job.properties #7.3版本新增,用于afc-xxl集成

9.damp/config/application-metacube.properties #7.3.1版本新增,用于采集器集成

1)公共配置:damp/config/application.properties

server.port=28078 ###可根据实际情况修改,注意端口冲突

spring.application.name=DAMP ###原则上不允许修改

server.servlet.session.timeout=PT120M

spring.session.store-type=none

server.app-server.accept-count=1000

server.app-server.max-connections=10000

server.app-server.max-threads=500

server.app-server.min-space-threads=50

#file upload

spring.servlet.multipart.max-file-size=100MB ###文件上传大小限制,与nginx配套修改

spring.servlet.multipart.max-request-size=100MB ###同上

#spring.profiles.active=eureka

spring.profiles.active=nacos,afc,damp,dm,job

spring.autoconfigure.exclude=org.springframework.boot.autoconfigure.mongo.MongoAutoConfiguration

management.endpoints.web.exposure.include=hystrix.stream,health,info,loggers,eos,mappings

out.config.folder=config

eos.application.sys-code=EOS-DEMO-SYS ###EOS默认配置,可以不修改。如果在Governor中配置需要根据配置情况修改

eos.application.sys-key=dc6baaed30e541d78bb91274803d9432 ###同上

# eos environment: dev prod test

eos.profiles.active=dev

# eos-cache

eos.cache.mode=redis

spring.redis.host=127.0.0.1 ###修改redis对应ip,本机则不需要修改

spring.redis.port=6379 ###修改redis对应端口,默认端口不需要修改

spring.redis.password= ###如果redis开启认证则需要配置密码

spring.redis.lettuce.pool.max-active=100

spring.redis.lettuce.pool.max-idle=100

spring.redis.lettuce.pool.max-wait=5000

2)afcenter组件配置:damp/config/application-afc.properties

afc.application.name=AFCENTER ###根据实际情况修改

afc.application.tenant=sys_tenant

bps.application.name=BPS-SERVER ###根据实际情况修改

bps.tenant.id=

# attachment

# mode: local,db,nexus,aliyun-oss,minio ###7.3.1 新增minio

afc.attachments.persistence-mode=local ###根据实际情况修改

afc.attachments.local.dir=

afc.attachments.nexus.repository-url=

afc.attachments.nexus.username=

afc.attachments.nexus.password=

afc.attachments.aliyun-oss.endpoint=

afc.attachments.aliyun-oss.access-key-id=

afc.attachments.aliyun-oss.access-key-secret=

afc.attachments.aliyun-oss.bucket-name=

afc.attachments.libre-office.host=

afc.attachments.libre-office.port=

# 公共资源管理模块配置

# if use nacos/eureka

public-resource.application.name=PUBLIC-RESOURCE ###根据实际情况修改

# else

public-resource.application.name=AFCENTER

3)damp组件配置:damp/config/application-damp.properties

eos.export.depend-api-contributions=com.primeton.data.dam.api

# dm

dm.application.name=127.0.0.1:28078 ###7.2版本引入了建模模块,因此改成本地接口调用,后续版本会替换成sdk

# quality

quality.application.name=QUALITY ###数据质量应用名,用于接口调用访问,可以配置成ip+端口,也可以配置成应用名

# damp security filter

damp.user.request.filter.enabled=false

damp.user.request.filter.keywords=is_admin,role,is_sso,isadmin,issso

damp.user.request.filter.pagesize=limit,pageSize ###7.3.1增加安全过滤拦截

4)注册中心配置:damp/config/application-nacos.properties

spring.cloud.nacos.discovery.enabled=true

spring.cloud.nacos.discovery.server-addr=127.0.0.1:8848 ###根据实际情况修改

#spring.cloud.nacos.discovery.username=nacos

#spring.cloud.nacos.discovery.password=nacos

eureka.client.enabled=false

5)配置中心配置:damp/config/bootstrap.properties

spring.cloud.nacos.config.enabled=true

spring.cloud.nacos.config.server-addr=127.0.0.1:8848 ###根据实际情况修改

#spring.cloud.nacos.config.username=nacos

#spring.cloud.nacos.config.password=nacos

6)数据源配置:damp/config/DAMP/config/user-config.xml

...

<group name="default"> ### 根据实际情况修改

<configValue key="Database-Type">MySql</configValue>

<configValue key="Jdbc-Type"/>

<configValue key="C3p0-DriverClass">com.mysql.jdbc.Driver</configValue>

<configValue key="C3p0-Url">jdbc:mysql://127.0.0.1:3306/damp?useUnicode=true&characterEncoding=UTF-8&serverTimezone=GMT%2B8&useSSL=false</configValue>

<configValue key="C3p0-UserName">username</configValue>

<configValue key="C3p0-Password">password</configValue>### 明文密码,启动后会自动加密

<configValue key="C3p0-PoolSize">10</configValue>

<configValue key="C3p0-MaxPoolSize">50</configValue>

<configValue key="C3p0-MinPoolSize">10</configValue>

<configValue key="C3p0-MaxIdleTime">600</configValue>

<configValue key="C3p0-IdleConnectionTestPeriod">900</configValue>

<configValue key="C3p0-MaxStatements">0</configValue>

<configValue key="C3p0-NumHelperThreads">1</configValue>

<configValue key="Transaction-Isolation">ISOLATION_DEFAULT</configValue>

<configValue key="Test-Connect-Sql">SELECT count(*) from EOS_UNIQUE_TABLE</configValue>

<configValue key="Retry-Connect-Count">1</configValue>

</group>

...

7)建模配置:damp/config/application-dm.properties

#jackson

spring.jackson.date-format=yyyy-MM-dd HH:mm:ss

spring.jackson.time-zone=GMT+8

spring.jackson.default-property-inclusion=non-null

spring.jackson.deserialization.fail-on-unknown-properties=false

#jpa

spring.jpa.open-in-view=false

spring.jpa.properties.javax.persistence.validation.mode=none

spring.jpa.hibernate.ddl-auto=none

spring.jpa.properties.hibernate.show_sql=true

spring.jpa.properties.hibernate.format_sql=true

spring.jpa.show-sql=false

## Database Dialect 数据库方言设置,如数据库不是MYSQL请根据实际情况放开对应数据库注释

## MySQL

spring.jpa.properties.hibernate.dialect=org.hibernate.dialect.MySQL5Dialect

## Oracle

# spring.jpa.properties.hibernate.dialect=org.hibernate.dialect.Oracle10gDialect

## SQLServer

# spring.jpa.properties.hibernate.dialect=org.hibernate.dialect.SQLServer2012Dialect

## Dameng

#spring.jpa.properties.hibernate.dialect=org.hibernate.dialect.DmDialect

### GaussDB

#spring.jpa.database=postgresql

#spring.jpa.properties.hibernate.dialect=org.hibernate.dialect.PostgreSQL9Dialect

#spring.jpa.properties.hibernate.temp.use_jdbc_metadata_defaults = false

#task

spring.task.scheduling.pool.size=5

spring.task.execution.pool.core-size=50

spring.task.execution.pool.max-size=100

spring.task.execution.pool.queue-capacity=100000

#file upload

spring.servlet.multipart.max-file-size=100MB

spring.servlet.multipart.max-request-size=100MB

spring.servlet.multipart.enabled=true

spring.servlet.multipart.location=${user.dir}/data/upload-tmp

spring.servlet.multipart.file-size-threshold=100KB

management.endpoints.web.exposure.include=*

management.health.redis.enable=false

# damp

damp.application.name=127.0.0.1:28078 ###damp默认端口,根据实际情况修改

8)定时任务配置(7.3版本默认是关闭状态,无需修改,但是没有会报错):damp/config/application-job.properties

### web

management.health.mail.enabled=false

### mybatis

mybatis.mapper-locations=classpath*:mybatis-mapper/*Mapper.xml

#mybatis.type-aliases-package=com.xxl.job.admin.core.model

### xxl-job, email

spring.mail.host=smtp.qq.com

spring.mail.port=25

spring.mail.username=xxx@qq.com

spring.mail.from=xxx@qq.com

spring.mail.password=xxx

spring.mail.properties.mail.smtp.auth=true

spring.mail.properties.mail.smtp.starttls.enable=true

spring.mail.properties.mail.smtp.starttls.required=true

spring.mail.properties.mail.smtp.socketFactory.class=javax.net.ssl.SSLSocketFactory

### afc-job, access token

#xxl.job.accessToken=

### afc-job, i18n (default is zh_CN, and you can choose "zh_CN", "zh_TC" and "en")

xxl.job.i18n=zh_CN

## afc-job, triggerpool max size

xxl.job.triggerpool.fast.max=200

xxl.job.triggerpool.slow.max=100

afc.job.admin.enabled=false

afc.job.executor.enabled=false

### afc-job, log retention days

xxl.job.logretentiondays=30

# executor

### xxl-job, access token

#afc.job.executor.accessToken=default_token

#afc.job.executor.address=

#afc.job.executor.ip=

#afc.job.executor.port=9999

#afc.job.executor.logPath=

#afc.job.executor.logRetentionDays=

9)元数据采集器配置(7.3.1版本新增,集成元数据采集器):damp/config/application-metacube.properties

# extractorDB 元数据采集数据源信息

extractor.datasource.url=jdbc:mysql://127.0.0.1:3306/damp?useUnicode=true&characterEncoding=UTF-8&useSSL=false&serverTimezone=Asia/Shanghai

extractor.datasource.driverClass=com.mysql.jdbc.Driver

extractor.datasource.username=root

extractor.datasource.password=primeton

# 第五步.dataEngine 后端部署

# 1.解压介质

1. 在/opt/primeton/server下创建 dataengineprod、dataenginedev 目录。其中 dataengineprod 是生产环境引擎,dataenginedev 是测试环境引擎。

2. 将 Primeton_DAMP_7.3.1_DataEngine.tar.gz 复制到 dataengineprod、dataenginedev 目录下,解压后将数据库驱动放到 lib 目录下。

# 2.配置文件修改

数据资产后端配置文件如下:

server/dataengineprod/config/application.properties

server/dataenginedev/config/application.properties

生产环境配置:server/dataengineprod/config/application.properties

#-根据实际情况修改 PROD/DEV

spring.application.name=DataEnginePROD

server.port=10010

server.tomcat.max-connections=10000

server.tomcat.max-threads=1000

server.tomcat.min-spare-threads=100

# alibaba nacos

spring.cloud.nacos.discovery.enabled=true

spring.cloud.nacos.discovery.server-addr=127.0.0.1:8848 ###nacos注册中心配置,根据实际情况修改

spring.cloud.nacos.discovery.username=nacos ###nacos注册中心配置,根据实际情况修改

spring.cloud.nacos.discovery.password=nacos ###nacos注册中心配置,根据实际情况修改

spring.servlet.multipart.enabled=true

spring.servlet.multipart.max-request-size=100MB

spring.servlet.multipart.max-file-size=20MB

spring.servlet.multipart.location=${user.dir}/data/upload-tmp

spring.servlet.multipart.file-size-threshold=100KB

spring.jackson.date-format=yyyy-MM-dd HH:mm:ss

spring.jackson.time-zone=GMT+8

spring.jackson.default-property-inclusion=ALWAYS

spring.jackson.deserialization.fail-on-unknown-properties=false

spring.task.scheduling.pool.size=5

spring.task.execution.pool.core-size=50

spring.task.execution.pool.max-size=100

spring.task.execution.pool.queue-capacity=100000

management.endpoints.web.exposure.include=*

#-根据实际情况修改数据库配置

spring.datasource.driver-class-name=com.mysql.cj.jdbc.Driver

spring.datasource.url=jdbc:mysql://127.0.0.1:3306/damp?useUnicode=true&characterEncoding=UTF-8&useSSL=false&serverTimezone=GMT%2b8

spring.datasource.username=root

spring.datasource.password=primeton

spring.datasource.pool-name=default

spring.datasource.minimum-idle=1

spring.datasource.maximum-pool-size=5

#-根据实际情况修改Redis配置

spring.redis.host=127.0.0.1 ###redis配置,根据实际情况修改

#spring.redis.port=6379 ###redis配置,根据实际情况修改

engine.runtime.group=DEFAULT

#-根据实际情况修改 PROD/DEV

engine.runtime.env=PROD

# engine.cache.notify.enabled=false

# none/memory/redis

# engine.security.token-cache.type=redis

# memory/redis

# engine.security.permission-cache.type=redis

# memory/none

# engine.service.spec-cache.type=none

# SQL SERVICE

#service.sql.query.order-column-limits=3

# engine.schedule.spec-cache-cleanup.cron=* 0/10 * * * ?

# Disabled by `-`

engine.schedule.spec-cache-sync.cron=-

# engine.schedule.spec-cache-sync.cron=* 0/10 * * * ?

afc.application.name=AFCENTER ###7.3.1新增,AFCENTER应用名,用户第三方脱敏加密获取token认证使用,根据实际情况修改

测试环境配置:server/dataenginedev/config/application.properties

##-引擎环境配置,生产:PROD,测试:DEV

engine.runtime.env=DEV ###环境变量配置

##-根据实际情况修改,生产和测试环境需要所有区分,建议:DataEnginePROD/DataEngineDEV

spring.application.name=DataEngineDEV

server.port=10011

server.tomcat.max-connections=10000

server.tomcat.max-threads=1000

server.tomcat.min-spare-threads=100

# alibaba nacos

spring.cloud.nacos.discovery.enabled=true

spring.cloud.nacos.discovery.server-addr=127.0.0.1:8848

spring.cloud.nacos.discovery.username=nacos

spring.cloud.nacos.discovery.password=nacos

spring.servlet.multipart.enabled=true

spring.servlet.multipart.max-request-size=100MB

spring.servlet.multipart.max-file-size=20MB

spring.servlet.multipart.location=${user.dir}/data/upload-tmp

spring.servlet.multipart.file-size-threshold=100KB

spring.jackson.date-format=yyyy-MM-dd HH:mm:ss

spring.jackson.time-zone=GMT+8

spring.jackson.default-property-inclusion=ALWAYS

spring.jackson.deserialization.fail-on-unknown-properties=false

spring.task.scheduling.pool.size=5

spring.task.execution.pool.core-size=50

spring.task.execution.pool.max-size=100

spring.task.execution.pool.queue-capacity=100000

management.endpoints.web.exposure.include=*

#-根据实际情况修改数据库配置

spring.datasource.driver-class-name=com.mysql.cj.jdbc.Driver

spring.datasource.url=jdbc:mysql://127.0.0.1:3306/damp?useUnicode=true&characterEncoding=UTF-8&useSSL=false&serverTimezone=GMT%2b8

spring.datasource.username=root

spring.datasource.password=primeton

spring.datasource.pool-name=default

spring.datasource.minimum-idle=1

spring.datasource.maximum-pool-size=5

#-根据实际情况修改Redis配置

spring.redis.host=127.0.0.1

#spring.redis.port=6379

engine.runtime.group=DEFAULT

# engine.cache.notify.enabled=false

# none/memory/redis

# engine.security.token-cache.type=redis

# memory/redis

# engine.security.permission-cache.type=redis

# memory/none

# engine.service.spec-cache.type=none

# SQL SERVICE

#service.sql.query.order-column-limits=3

# engine.schedule.spec-cache-cleanup.cron=* 0/10 * * * ?

# Disabled by `-`

engine.schedule.spec-cache-sync.cron=-

# engine.schedule.spec-cache-sync.cron=* 0/10 * * * ?

afc.application.name=AFCENTER ###7.3.1新增,AFCENTER应用名,用户第三方脱敏加密获取token认证使用,根据实际情况修改

# 3.filebeat安装配置

用户服务调用会在logs目录下产生api.log日志,filebeat会采集日志并传输至logstash。因此在配置中注意api日志的绝对路径以及logstash服务地址和端口。

注意:

- filebeat 需要与Elasticsearch版本保持一致。

- filebeat 需要和 dataengine 安装在同一台服务器上。

# 启动&配置

#启动filebeat

[root@autotest-01 filebeat-7.0.0-linux-x86_64]# ./filebeat -c data-engine-filebeat.yml &

- filebeat:data-engine-filebeat.yml

filebeat.inputs:

- type: log

paths: ["/opt/primeton/server/dataengineprod/logs/api.log*"] ##服务引擎日志地址,根据实际安装情况修改路径

encoding: UTF-8

fields:

log-type: api-log

tags: ["api-log"]

exclude_files: [".gz$"]

json.keys_under_root: true

json.add_error_key: true

json.overwrite_keys: true

output:

logstash:

hosts: ["127.0.0.1:5044"] ##对应logstash访问地址,根据实际情况修改

# 4.logstash安装配置

logstash

注意:

- logstash 需要与Elasticsearch版本保持一致。

# 启动&配置

#启动logstash

[root@autotest-01 logstash-7.17.9]# ./bin/logstash -f config/data-engine.conf 2>&1 &

- logstash:data-engine.conf

input {

beats {

port => 5044 ##默认端口,如果冲突可修改,filebeat需要同步修改。

}

}

filter {

date {

match => [ "time", "UNIX_MS" ]

locale => "cn"

timezone => "Asia/Shanghai"

target => "covert-time"

}

# calculate time UTC + 8h -> Asia/Shanghai

ruby {

code => "event.set('covert-time', event.get('covert-time').time.localtime + 8*60*60)"

}

mutate {

convert => ["covert-time", "string"]

}

# -----

# replace logstash @timestamp with log timestamp, and output.elasticsearch create index use this time

# -----

date {

match => [ "covert-time", "YYYY-MM-dd'T'HH:mm:ss.SSSZ", "ISO8601" ]

locale => "cn"

timezone => "Asia/Shanghai"

}

}

output {

elasticsearch {

hosts => ["127.0.0.1:9200"] ##Elasticsearch访问地址,根据实际情况修改

index => "%{[fields][log-type]}-%{+YYYY.MM.dd}"

document_type => "log"

}

}

# 第六步.替换license文件(开发测试环境)

如果是开发测试环境,没有申请临时/正式license时,可以使用damp自带的产品license体验damp功能。

license(源):/opt/primeton/server/damp/config/DAMP/license/primetonlicense.xml

license(目标):/opt/primeton/server/primetonlicense.xml

如果申请license,则注意增加数据资产相关组件 data-asset,data-catalog,data-standard。

# 第七步.前端配置

# 1.解压介质

- 解压 Primeton_DAMP_7.3.1_UI.tar.gz,在web目录下的 dam 、 dataService 、 dm 3个文件夹。

- 将3个文件夹复制到前端afcenter目录下 /opt/primeton/web/afcenter即可。

# 2. 配置文件修改

- 在 nginx 安装目录下的 conf/nginx.conf 配置文件中增加数据资产前端配置,在配置文件中添加 include /home/primeton/web/conf/*.conf; ##-根据实际情况修改文件路径。

user root; ###根据实际用户配置,建议使用root启动

worker_processes 1; ###根据实际情况配置,除非测试环境否则不建议1

#error_log logs/error.log;

#error_log logs/error.log notice;

#error_log logs/error.log info;

#pid logs/nginx.pid;

events {

worker_connections 1024;

}

http {

include mime.types;

default_type application/octet-stream;

client_max_body_size 100M;

client_body_buffer_size 10M;

fastcgi_intercept_errors on;

#log_format main '$remote_addr - $remote_user [$time_local] "$request" '

# '$status $body_bytes_sent "$http_referer" '

# '"$http_user_agent" "$http_x_forwarded_for"';

#access_log logs/access.log main;

sendfile on;

#tcp_nopush on;

#keepalive_timeout 0;

keepalive_timeout 65;

#gzip on;

include /home/primeton/web/conf/*.conf; ##-根据实际情况修改文件路径

}

- 检查 nginx 配置文件,配置在 /opt/primeton/web/conf/eos8.conf。默认不需要做特殊配置。

upstream eosgateway {

server 127.0.0.1:9090; #gateway默认端口

}

#EOS afcenter by gateway

server {

listen 80;

#client_body_buffer_size 10m; #缓存区大小

client_max_body_size 100m;

#默认没有,元数据集成配置,如果不做单点登录可以不配。

location /fd_dgs/ {

proxy_pass http://127.0.0.1:83/ ;

}

#默认没有,元数据集成配置,如果不做单点登录可以不配。

location ^~ /dgs {

charset utf-8;

proxy_pass http://127.0.0.1:28079;

}

location ~ /(.*)/api/ {

proxy_set_header X-EOS-SourceSysKey dc6baaed30e541d78bb91274803d9432;

proxy_pass http://eosgateway;

}

location ~ \.biz\.ext$ {

proxy_set_header X-EOS-SourceSysKey dc6baaed30e541d78bb91274803d9432;

proxy_pass http://eosgateway;

}

location / {

root "/opt/primeton/web/afcenter";

access_log /opt/primeton/web/logs/access.log ;

error_log /opt/primeton/web/logs/error.log warn;

index index.html index.htm;

try_files $uri /index.html;

}

}

#元数据,也可单独增加一个metacube.conf

server {

listen 83;

proxy_buffer_size 128k;

proxy_buffers 32 128k;

proxy_busy_buffers_size 128k;

proxy_set_header Host $host;

proxy_set_header X-Real-IP $remote_addr;

proxy_set_header X-Real-Port $remote_port;

proxy_set_header REMOTE-HOST $remote_addr;

proxy_set_header X-Forwarded-For $proxy_add_x_forwarded_for;

location / {

root /home/primeton/web/metacube;

index index.html index.htm;

try_files $uri /index.html;

}

location /dgs {

charset utf-8;

proxy_pass http://127.0.0.1:28079;

}

}

# 第八步.启动服务

# 后端启动

Linux 系统

[root@localhost server]# ./damp/bin/startup.sh

[root@localhost server]# ./dataengineprod/bin/startup.sh

[root@localhost server]# ./dataenginedev/bin/startup.sh

Windows 系统

D:\Desktop\server> ./damp/bin/startup.cmd

D:\Desktop\server> ./dataengineprod/bin/startup.cmd

D:\Desktop\server> ./dataenginedev/bin/startup.cmd

# 前端启动

Linux 系统

[root@localhost nginx]# ./sbin/nginx

Windows 系统

D:\Desktop\server> nginx.exe

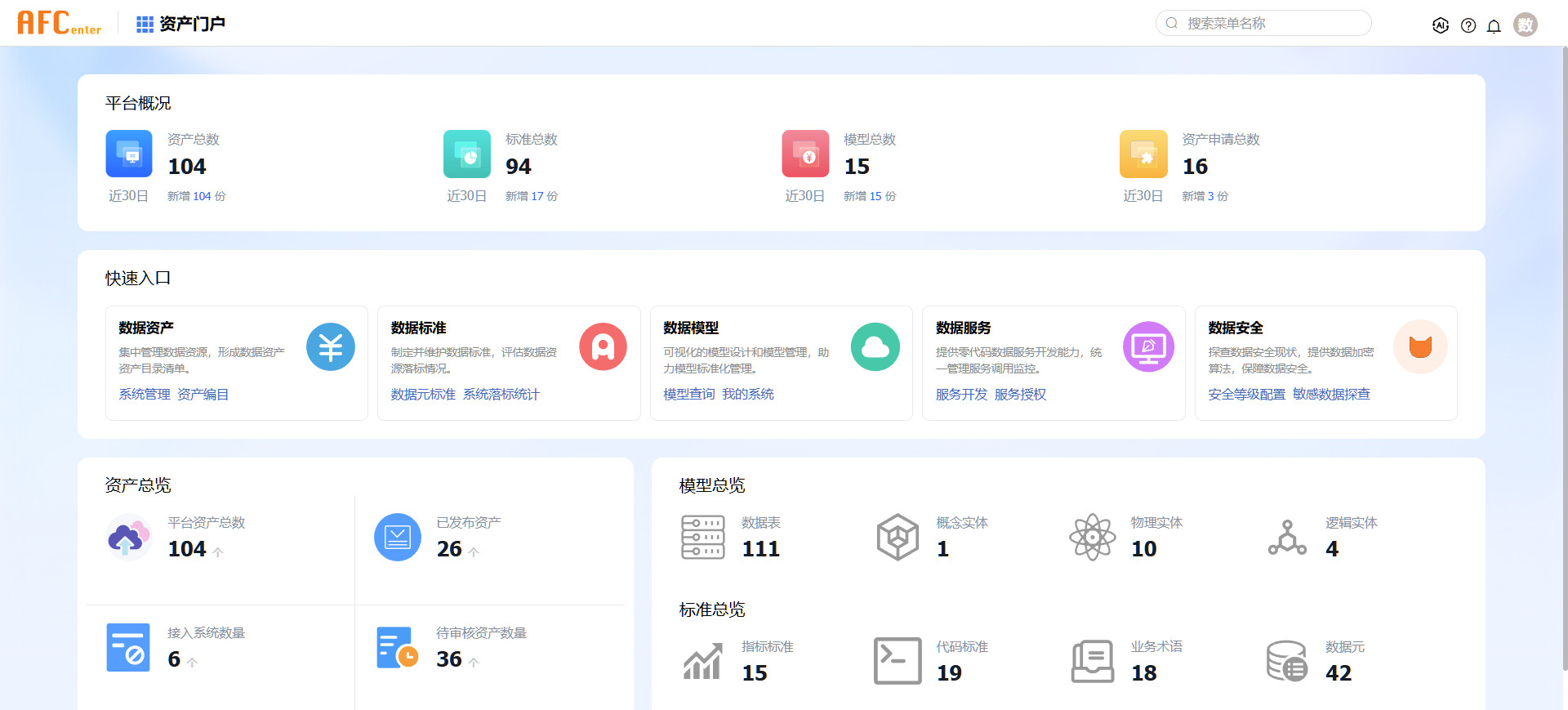

# 第九步.环境登录和验证

访问 http://localhost,使用初始用户登录,初始用户名、密码为:dtadmin/000000。

若无法访问,检查是否角色授权!!!

# 第十步.平台配置

第一次登录系统后需要修改部分平台参数,其中必须初始化的配置参数包括元数据配置、服务引擎、搜索引擎。修改配置后需要重新启动DAMP后端应用。

PS:也可以直接在数据库中修改,平台配置表:comp_system_config。

修改完成后建议重启DAMP。

# 元数据配置

元数据集成相关配置

修改元数据集成方式。如果元数据是独立安装,。

修改元数据地址。如果元数据和DAMP安装在同一台服务器上并且dgs端口未修改,则不需要调整。

关键参数说明:

metacube.isAlone : 元数据集成方式如果是独立安装修改为 Y,如果是集成采集器安装修改为 N。

metacube.rmiport :元数据独立安装请忽略,集成采集器安装默认9996 不冲突于采集器端口(9998)即可。

metacube.rmihost :元数据独立安装请忽略,集成采集器安装默认127.0.0.1 该IP为DAMP所在服务器IP

metacube.serverUrl : 元数据dgs后端服务地址。如果元数据和DAMP安装在同一台服务器上并且dgs端口未修改,则不需要调整。

# 服务引擎配置

服务引擎对应后端 dataserviceprod 和 dataservicedev 对应端口,此处配置的地址需要是真实ip地址,不能配置成127.0.0.1。此配置修改后不需要重启服务。

关键参数说明:

dataEngine.gatewayUrl : 服务引擎生产环境地址,主要作用于页面服务地址显示。

dataEngine.gatewayUatUrl :服务引擎测试环境地址,主要应用服务现在测试时调用服务时使用。

dataEngine.isNeedDev: 服务引擎默认不需要预发布,如果需要预发布动作修改为 true

# 修改搜索引擎配置(重启后生效)

默认使用elasticsearch作为搜索引擎,用户需要按照安装的es服务地址配置,修改后需要重启才会生效。

关键参数说明:

searchEngine.engineUrl : es的http服务地址,支持https。

searchEngine.engineUserName :es认证账号,如果es开启了xpack账号密码认证,则需要填写。

searchEngine.enginePassword :es认证密码,如果es开启了xpack账号密码认证,则需要填写。

# 修改数据质量集成配置

如果安装了数据质量组件,可以通过修改配置实现集成。配置后可以通过数据元标准维护自动生成数据质量规则,并可以在标准监控中查看规则执行情况。

关键参数说明:DAM_BUILD_QUALITY.IS_OPEN : 是否启用数据质量集成配置,设置“Y/N”。

# 修改数据模型集成配置

7.3版本中集成了数据建模组件,因此默认配置会开启。此配置默认不需要修改。

关键参数说明:

DAM_BUILD_MODEL.IS_OPEN : 默认打开,如果不需要可以设置成N。

DAM_BUILD_MODEL.MODEL_URL : 数据开发前端跳转地址,默认不需要修改。

# 修改公共资源集成配置

公共资源集成是否开启。开启后支持资产分类同步公共资源主题分类信息

关键参数说明:

DAM_PUBLIC_RESOURCE.IS_OPEN : 默认关闭,如果需要可以设置成 Y ,开启后支持资产分类同步公共资源主题分类信息。

# 第十一步.权限配置

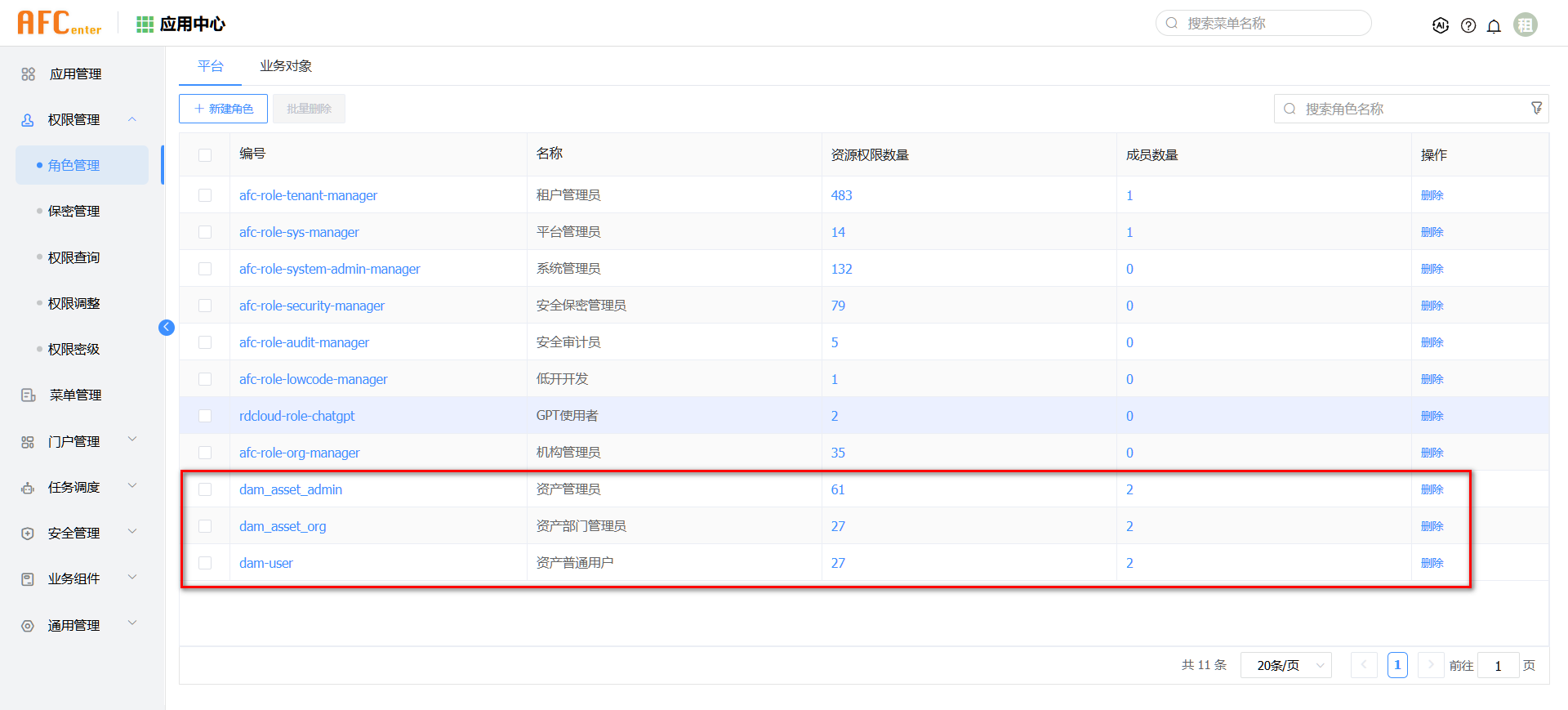

在使用平台前,需要给数据资产管理员、部门管理员、资产普通用户角色增加部分系统权限。

使用超级管理员 admin 进行角色授权,登录系统后在 应用中心->权限管理->角色管理。

- 找到【资产管理员】、【资产部门管理员】、【资产普通用户】三个角色,分别添加系统权限.

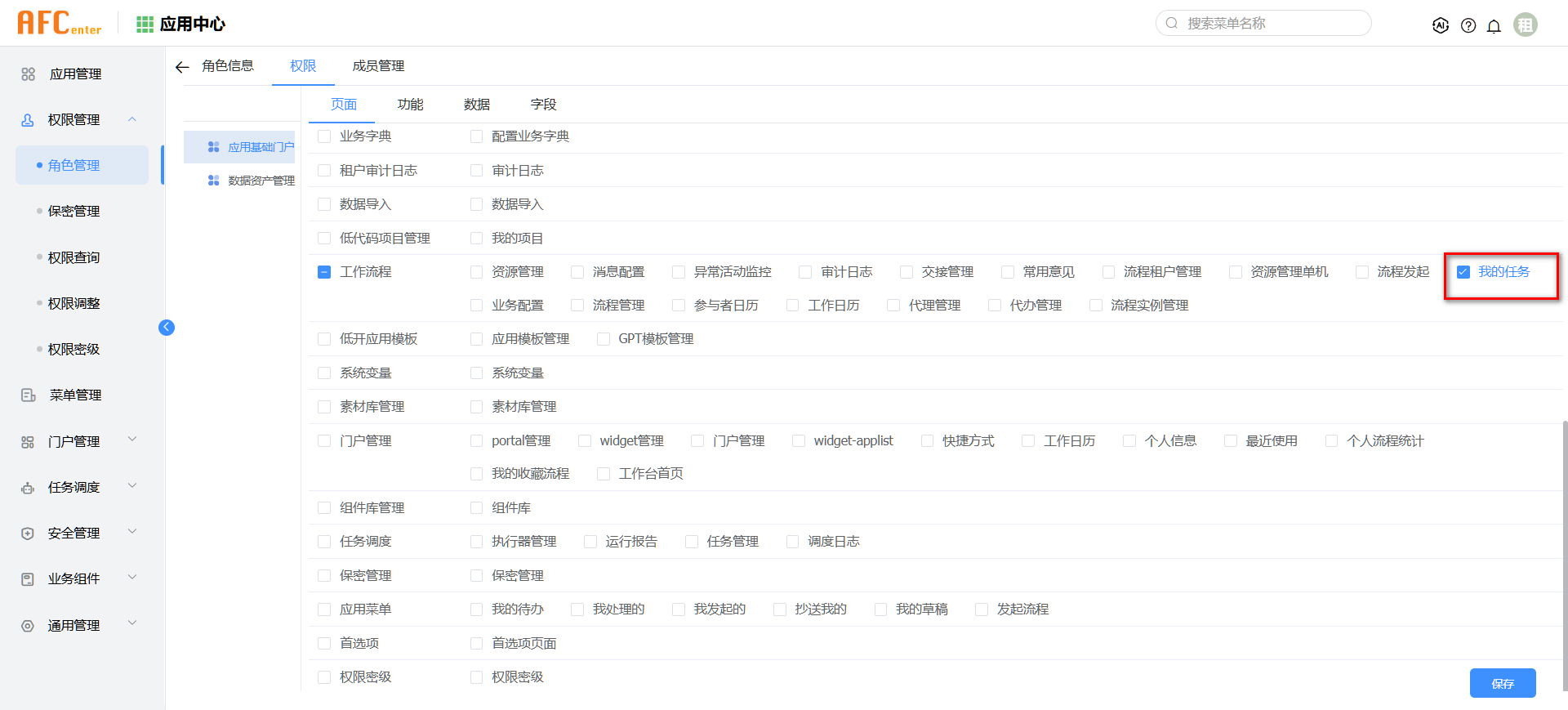

- 点击角色页面计入“权限”页签。

- 在左侧应用列表中找到“应用基础门户”,选中该应用在右侧“页面”页签中找到“工作流程”,勾选“我的任务”。(PS:其他的页面非必要,按需勾选即可)

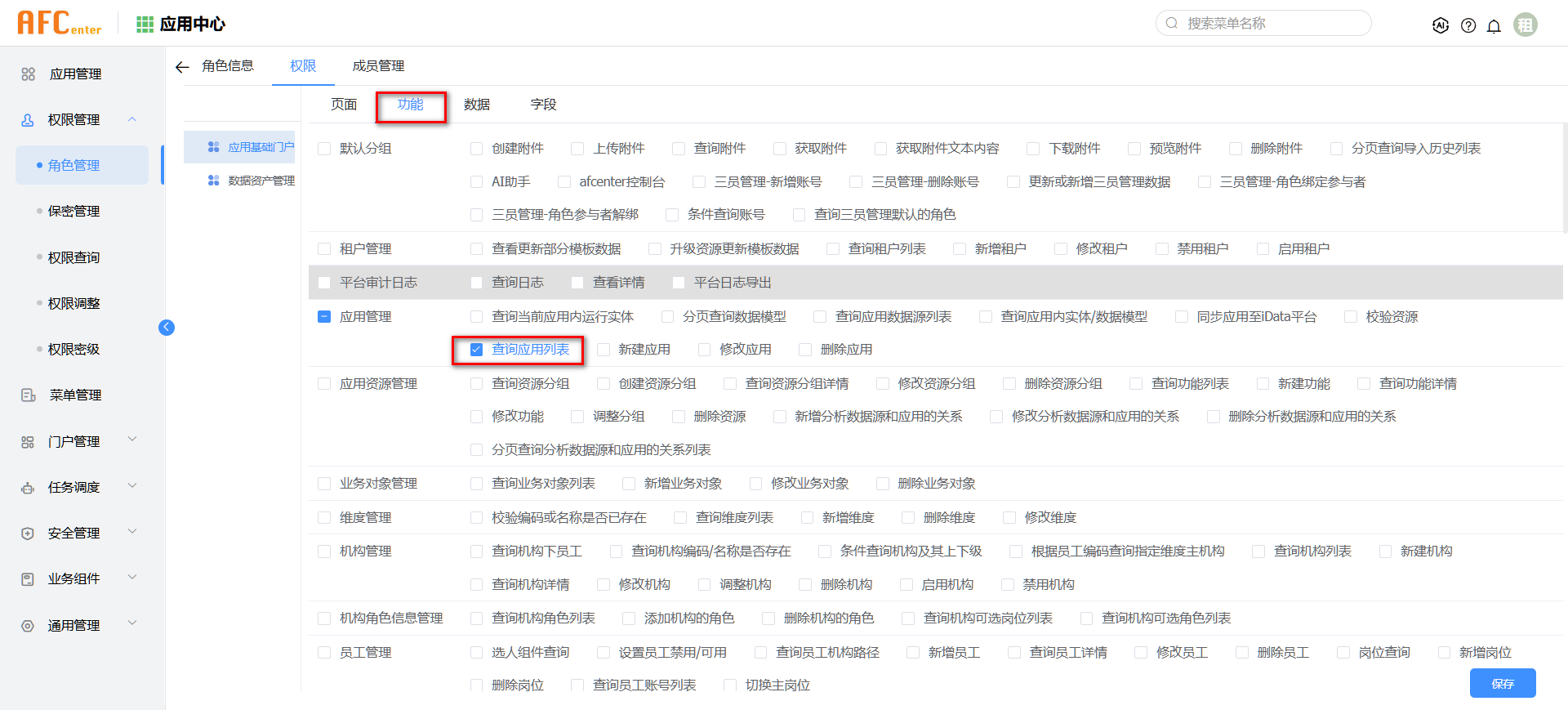

- 完成上一步操作后,选中上方”功能“页签,找到“应用管理”分类,勾选“查询应用列表功能”。

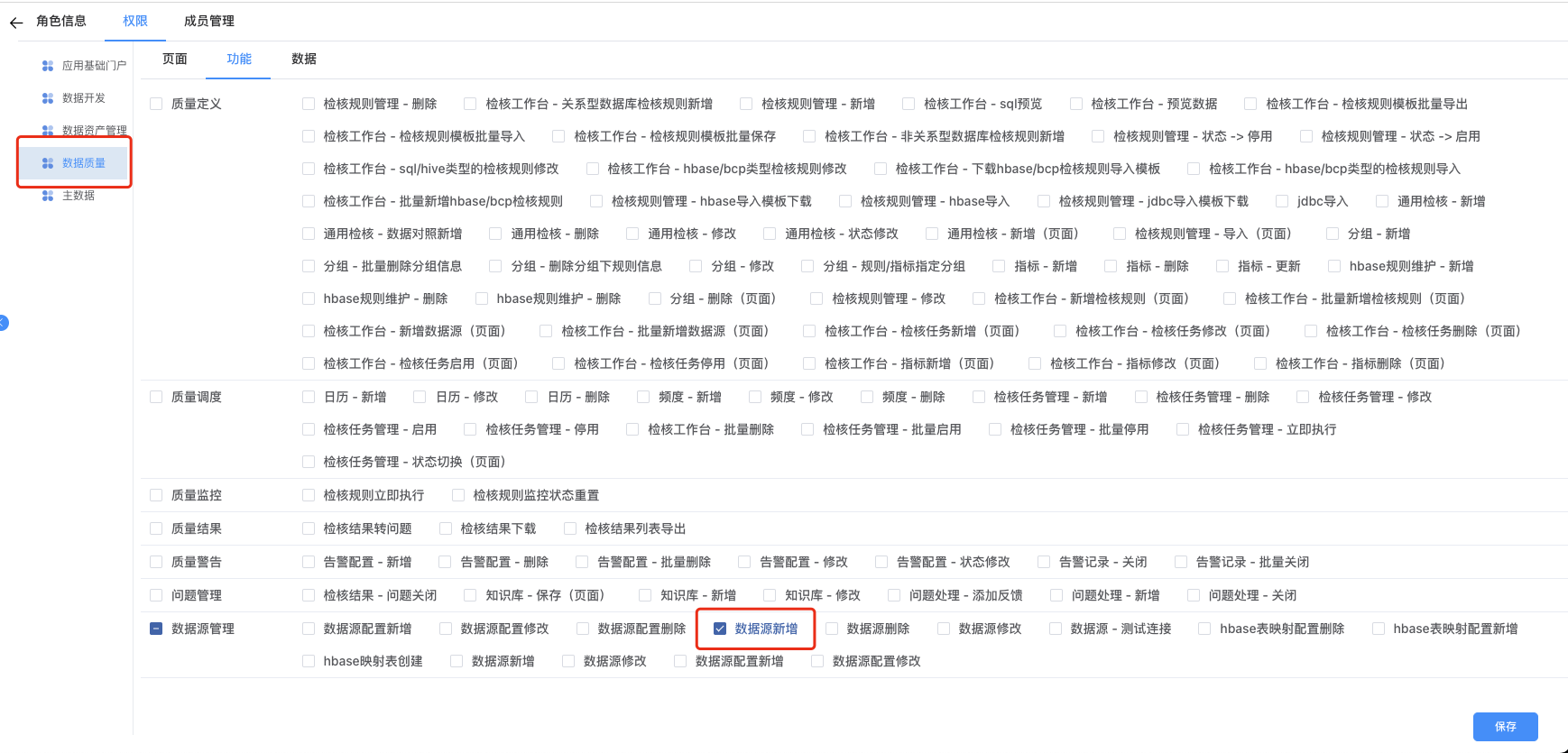

- 如果集成了数据质量,还需要额外的添加质量的权限。在安装完数据质量后,可以在左侧应用列中找到"数据质量",在“功能”页签中添加“”-“数据源新增”

- 完成后点击右下角“保存”。三个角色都要完成相同步骤,否则会影响流程处理。

# 第十二步.初始化Elasticsearch索引

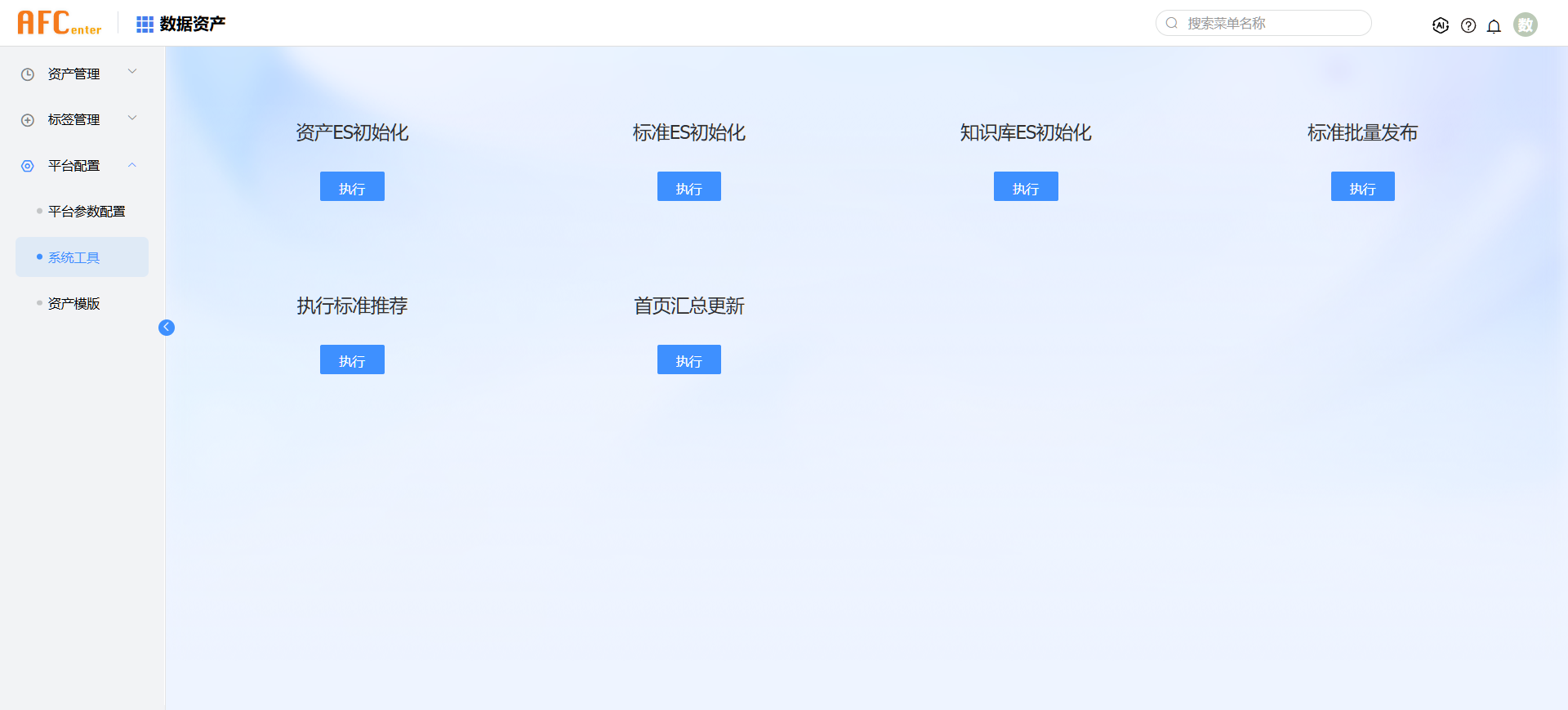

在【数据资产】-【平台配置】-【系统工具】中,点击“资产ES初始化”,“标准ES初始化”,“知识库ES初始化”按钮即可。

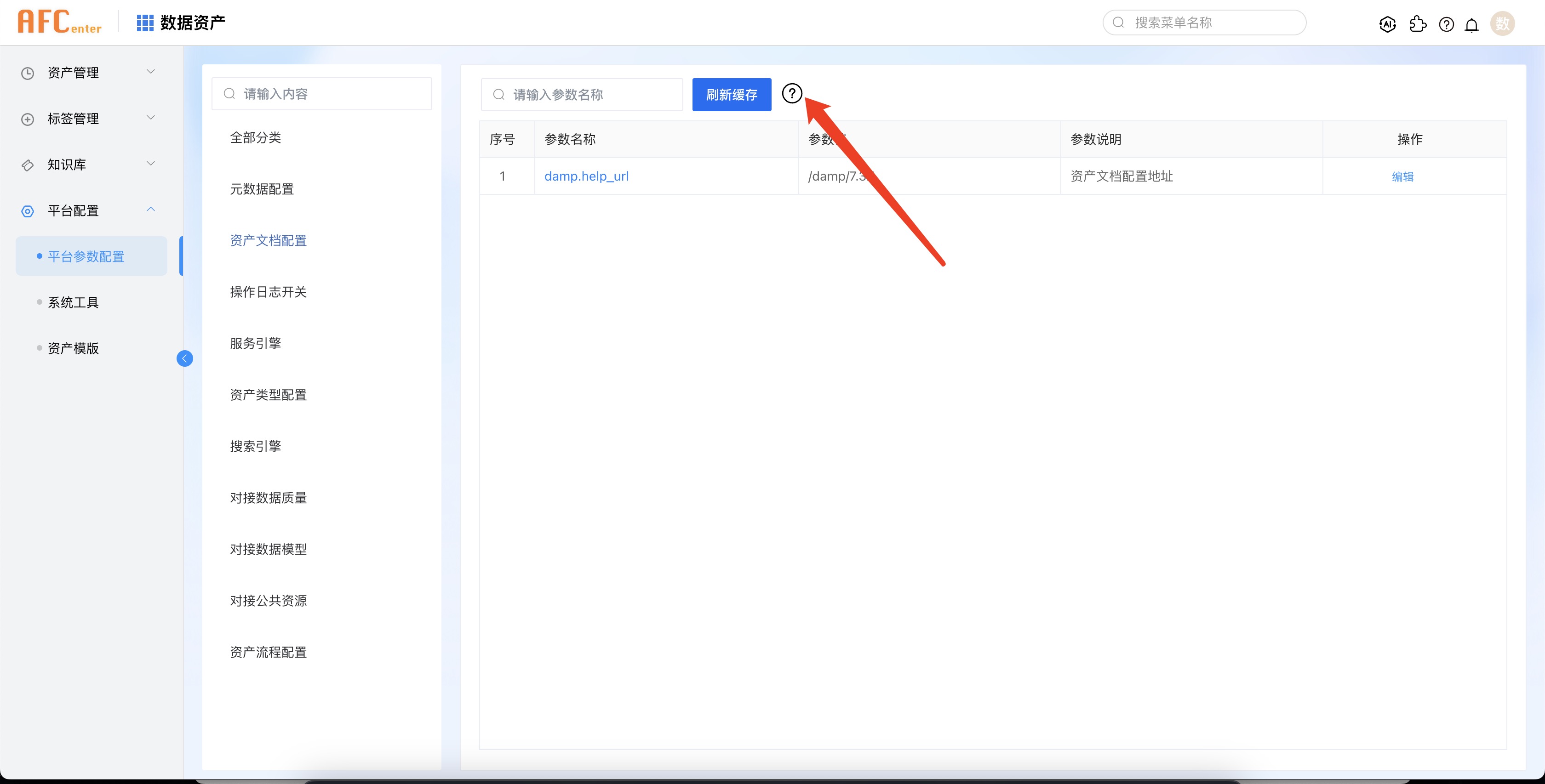

# 补充:在线文档本地部署

7.3.1版本提供了文档链接功能,在平台重要的页面中增加了问号图标,链接对应的在线文档地址。我们提供了公网可以直接访问的文档地址(http://help.primeton.com/damp/7.3.1/),也提供了本地部署的文档介质。如果网络无法直接访问公网的情况下,可以将文档介质部署到nginx中,实现在线文档的本地化部署和内网查阅。下文中将简单介绍本地化部署的步骤。

# 获取文档介质

从网盘中下载单独的文档介质Primeton_DAMP_7.3.1_Doc_Vuepress.zip。

注意:

- 介质并没有包含在Primeton_DAMP_7.3.1_MircorApp.tar.gz中。

# 介质部署

默认我们会将文档介质放到和数据资产前端相同的nginx中,避免新增额外的端口或者跨域访问的问题。

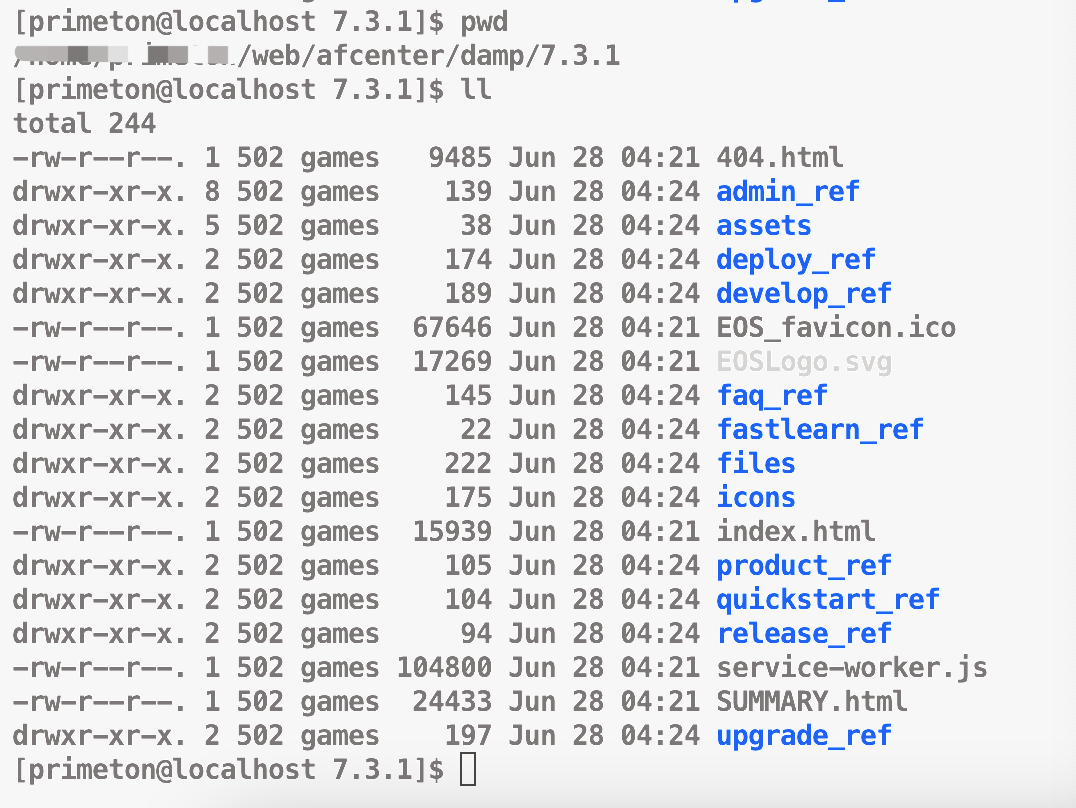

为了和公网地址保持一致,我们一般会在afcenter目录下创建damp/7.3.1目录,并将介质解压在对应目录下。

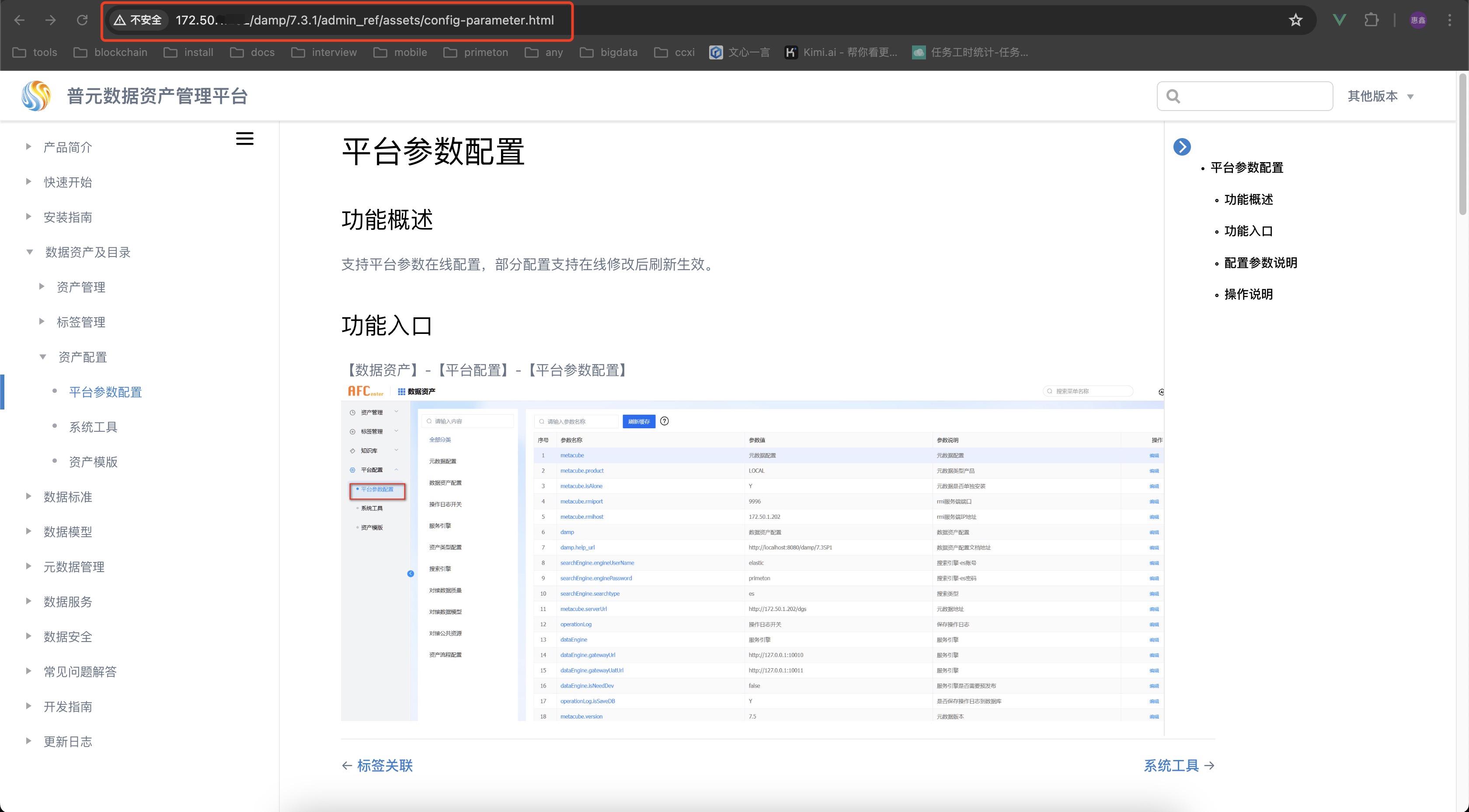

# 平台参数修改

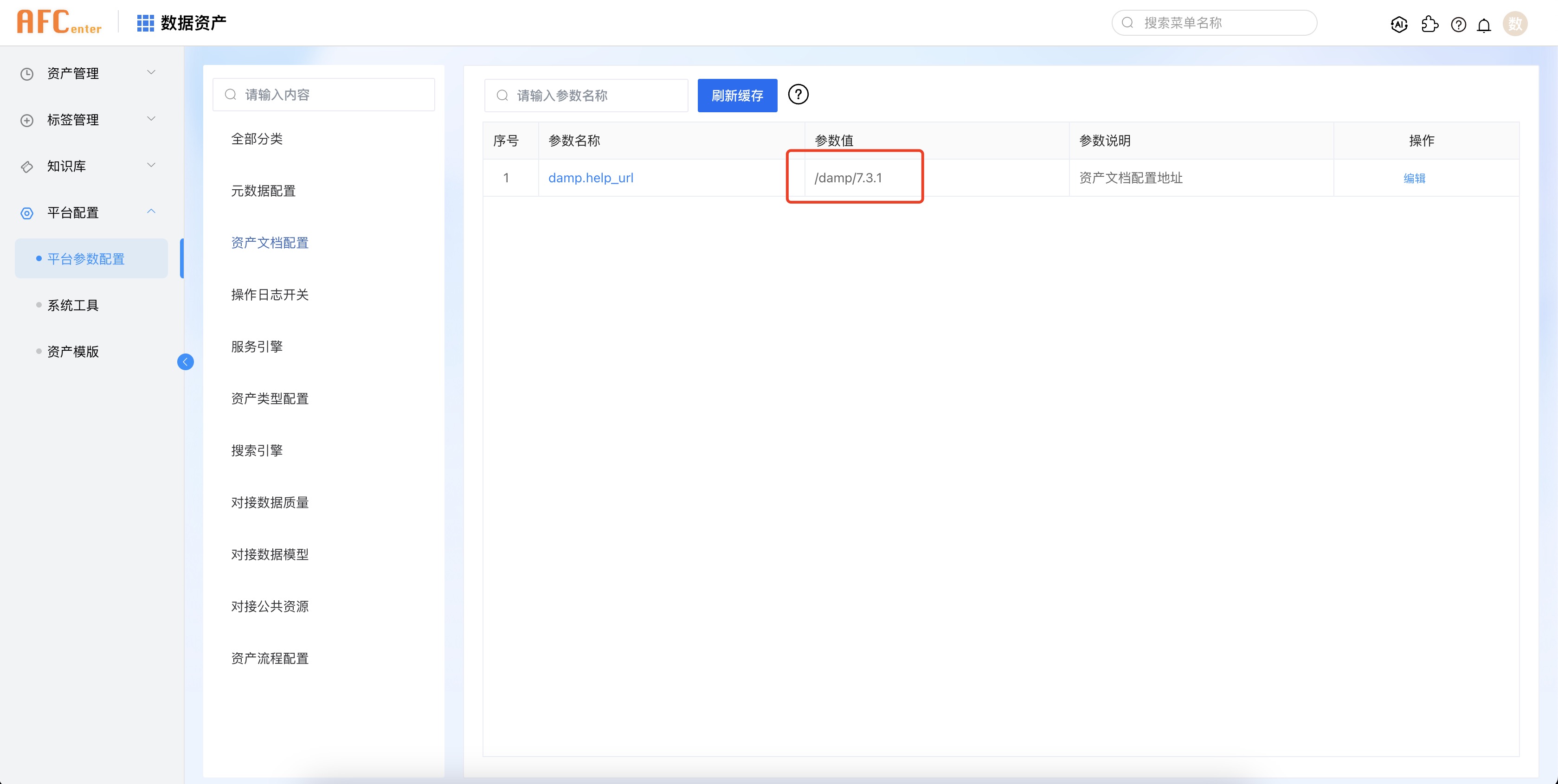

在平台参数配置中找到【资产文档配置】-【资产文档配置地址】参数,系统默认初始化的是公网地址。如果您按照上述步骤配置,则需要将参数值修改为“/damp/7.3.1”即可。此路径是一个相对路径,跳转时系统会根据默认服务地址拼接。如果您自定义了介质路径,则需要根据实际的配置情况来自行调整。

# 最终效果

配置生效后,点击【刷新缓存】边的问好图标,即可打开对应的文档页面。

此时访问路径就是内网地址。